Aus mehreren Gründen (und aus Rache gegen vermeintlichen Vendor-Lock-In) bin ich auch privat auf Zabbix umgestiegen. Mikrotik mit SNMP einbinden und abfragen? Easy Peasy!

Bis zum Tag X, an dem zwei weitere Mikrotik Geräte mit RouterOS dazu kamen. Nix zu wollen! Ich dachte erst es ist ein Template-Problem bei Zabbix, weil ich Switche (aus guten Gründen, Danke Sandro 😉 mit RouterOS betreiben wollte.

cannot read from session: Bad parse of ASN.1 type (plaintext scopedPDU header type

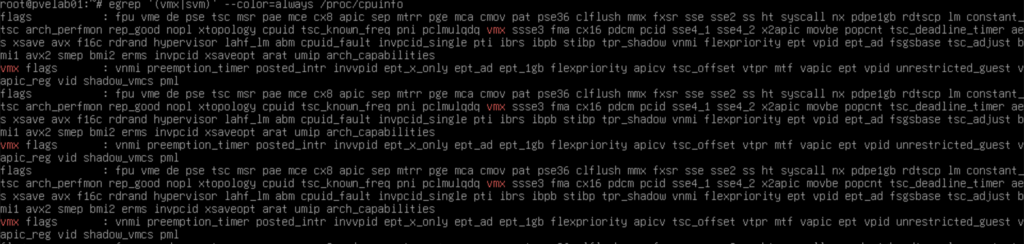

snmpwalk mit v3, sah alles Top aus, keine Passwort oder IP oder Firewall Probleme. Alles ausgeschlossen. Nur sobald ich das in Zabbix haben wollte -> Nada!

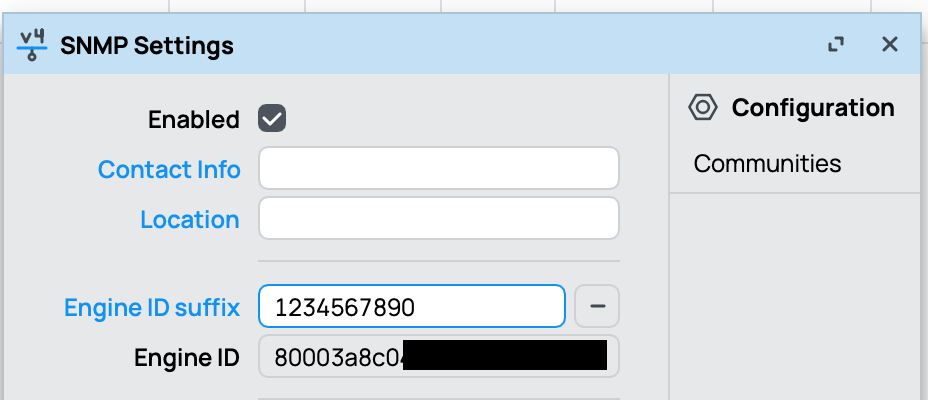

Stunden später bin ich auf einen Beitrag aufmerksam geworden, dass die EngineID unterschiedlich sein muss, das auch sollte, aber aus irgendwelchen Gründen bei Mikrotik gleich ist.

Einfach einen eindeutigen String bei Engine ID suffix (ich hab mich dann für die Primäre MAC-Adresse ohne Doppelpunkte/Striche entschieden) eintragen, und das Thema ist durch.